搜索引擎蜘蛛抓取索引不收录网站的原因

![]() 游客

2024-03-22 15:52:01

229

游客

2024-03-22 15:52:01

229

搜索引擎蜘蛛抓取索引不收录网站的原因

搜索引擎已经成为人们获取信息的主要渠道,随着互联网的飞速发展。不被收录,但是有些网站却被搜索引擎忽略。这种现象背后的原因是什么呢?本文将对此进行详细介绍。

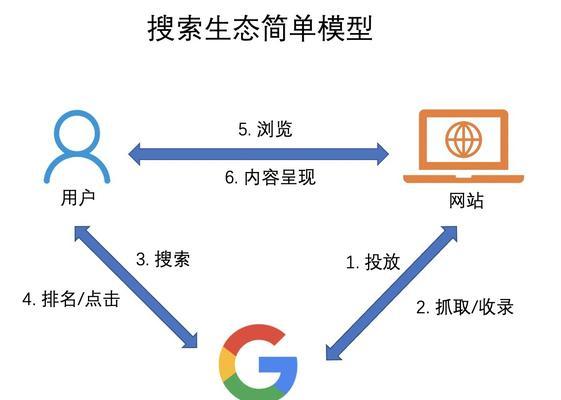

什么是搜索引擎蜘蛛

为什么蜘蛛没有收录网站

搜索引擎蜘蛛未收录某些网站的原因有很多种、其中最常见的包括以下几点:

1.缺乏原创性和价值性,不能提供有用的信息,网站质量不高。

2.导致蜘蛛无法顺利抓取,不规范、网站结构复杂。

3.影响蜘蛛的抓取效率,网站访问速度过慢。

4.txt文件限制了搜索引擎的访问权限,网站有robots。

5.垃圾信息等,如恶意链接,网站存在违规行为。

6.缺乏足够的外部链接信任度、网站还没有被其他网站链接。

网站质量不高

因此对于那些缺乏原创性和价值性的网站、往往会被忽略,搜索引擎的目标是为用户提供高质量的信息。或者根本就没有提供有用的信息,这些网站可能存在大量重复或低质量的内容。即使蜘蛛访问了该网站、在这种情况下,也不会将其收录到索引数据库中。

网站结构复杂

规范清晰的、一个好的网站结构应该是简单明了。就会使得蜘蛛无法正常抓取页面内容,导致页面嵌套深、链接不明确等问题,如果网站结构过于复杂。就难以保证该网站被收录到搜索引擎的索引数据库中,这样一来。

网站访问速度过慢

一个良好的网站应该具备较快的访问速度。很容易导致用户流失,如果用户等待时间过长。也会影响蜘蛛抓取效率、同样地,如果蜘蛛访问该网站需要很长时间。就很难被搜索引擎收录,如果一个网站访问速度过慢。

robots.txt文件限制

哪些页面应该排除,用于告诉搜索引擎哪些页面可以被访问,txt文件是一种机器人排除协议,robots。那么就会导致部分页面无法被收录到搜索引擎的索引数据库中,如果一个网站使用robots,txt文件限制了搜索引擎的访问权限。

违规行为

那么很容易被搜索引擎识别并加以惩罚,如果一个网站存在恶意链接,垃圾信息等违规行为。该网站很难被搜索引擎收录到索引数据库中,在这种情况下。

缺乏足够的外部链接信任度

外部链接信任度是指其他网站向该网站链接的数量和质量。那么就很难被认为是一个有价值和可信赖的网站,如果一个网站缺乏足够的外部链接信任度。即使蜘蛛访问了该网站,也不容易被收录到搜索引擎的索引数据库中、在这种情况下。

想要被搜索引擎收录需要考虑很多方面的因素,对于一个网站而言。无robots,才能够让搜索引擎蜘蛛更容易抓取索引并且收录、结构规范,遵守合法行为准则、只有确保网站质量高、访问速度快,拥有足够外部链接信任度等条件时,txt文件限制。

版权声明:本文内容由互联网用户自发贡献,该文观点仅代表作者本人。本站仅提供信息存储空间服务,不拥有所有权,不承担相关法律责任。如发现本站有涉嫌抄袭侵权/违法违规的内容, 请发送邮件至 3561739510@qq.com 举报,一经查实,本站将立刻删除。

转载请注明来自365seo,本文标题:《搜索引擎蜘蛛抓取索引不收录网站的原因》

标签:网站推广

- 搜索

- 最新文章

- 热门文章

-

- 百度简单搜索的用户体验如何?它的优势和劣势是什么?

- 推广网站有哪些策略?如何提高转化率?

- 为什么网站会被降权?常见原因有哪些?

- 看网站关键词排名优化怎么看

- 如何使用seo查询工具进行网站分析?

- 短视频关键词矩阵设置方法是什么?

- 影响seo排名的因素有哪些方面?如何优化提升网站排名?

- 咸宁网站关键词优化多久有排名

- 网站里面搜索关键词是什么

- 网站的长尾词排名优化用该怎么做?如何提升网站长尾关键词的SEO效果?

- 如何优化网站文章以提升收录率?收录率低的原因是什么?

- 网站优化的5个小技巧是什么?如何有效提升网站排名?

- 抖音关键词推广有哪些途径?

- 抖音关键词词包如何添加?提高搜索量的方法是什么?

- 网站SEO优化排名有哪些技巧?如何有效提升网站SEO排名?

- 谷歌怎么看关键词自然排名

- 网站设计的最新趋势是什么?如何优化关键词?

- 广东企业网站建设如何选择?如何提升网站用户体验?

- 淘宝英文关键词排行榜在哪里查看?如何分析关键词热度?

- 抖音搜索不到关键词时应如何解决?

- 热门tag

- 标签列表